Abstract

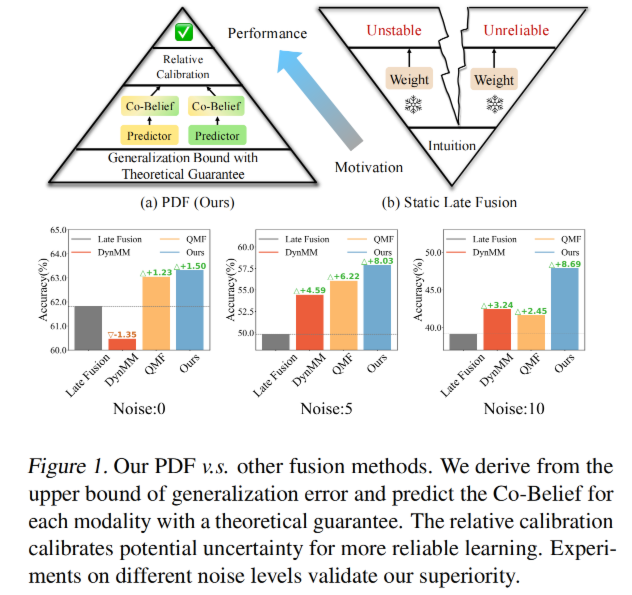

多模态融合在联合决策系统中对于做出总体决策是非常重要的,因为多模态数在开放的环境中发生改变,动态的融合在多个应用中取得了巨大进展.但是,大多数的动态多模态融合系统缺少理论的保证并且容易陷入局部最优解从而产生不可靠和不稳定.为了解决这个问题,我们提出了预测动态融合(PDF)架构.我们从泛化的角度揭示了多模态融合,并从理论上推导了具有单置信和全置信的可预测协同信念(共同信念),证明降低了泛化误差的上界。

Introcuction

为了尽可能的捕获互补信息,多模态融合成为一个很有前途的学习范式,它提供了一个整合所有可用的模式和实现增强的性能的机会。虽然听起来这么好,但是实验证明传统的融合技术忽略了多模态数据质量的动态变化.现实中,不同模态的数据质量和他们的内在联系往往随着开放环境的改变而改变.大量研究表明多模态学习有时候只依赖少部分模态甚至是单一模态,而别是在模态失衡或者高噪声的情况下.因此动态多模态学习成为了鲁棒融合的关键.一些研究表明数据量有限的情况下多模态学习并不总是优于单模态学习.

总体来说,根据总体数据质量来融合多模态信息是合理的.但是数据质量预测并不总是可靠的因为单模态的不确定性和多模态系统相对可靠性的变化.我们的实验证明每种模态的支配地位是随着环境的变化而变化的.基于这个理论,一个基础的可靠多模态学习就是==如何精确的预测每一种模态对多模态系统的贡献==.但是现有的架构通常使用动态神经网络或者评估每一种数据模态的不确定性,这些方法通常缺少理论的指导.

为了解决这个问题,我们重新审视了模态融合权重和损失之间的关系.基于泛化损失上界,我们揭示了减少泛化误差界的关键在于融合权重和当前模态损失之间的负协方差,以及融合权重与其他模态损失之间的正协方差.这意味着多模态系统融合权重不应该只依赖于单模态,而且应该强制融合其他模态的状况.一个自然地想法就是使用每个模态的损失来进行特征融合.但是直接预测 loss 是不可靠的,因为模型收敛的时候损失很小.在具有交叉熵损失函数的多模态分类任务中,我们把损失改为了正样本的置信度,并且满足泛化误差得到的相关性.

因此,我们在这个多模态融合的理论基础上提出了一种新的视角并且提出了 PDF 架构,它有效地降低了泛化误差的上界,显著提高了多模态的可靠性和稳定性.首先预测了每个模态的联合置信度

Theory

Basic Setting

给定一个多模态任务,我们定义 M 为多模态集合,|M|是 M 的基数.我们的目标是为每个模态预测融合权重 w.单模态映射函数在训练过程中动态的调整,最终的决策融合如下:

泛化误差上界

GEB 是机器学习中的重要概念,指的是对于一个未知的数据上模型的表现.通常越小的泛化误差代表模型的泛化能力更好,在未知的联合分布上的能力就越好.对于二分类,泛化误差可以写为:

其中 l 是逻辑损失函数,D 是一个位置的样本集,

- 3.1 经过一系列数学证明.并且才能让泛化误差最小

- 3.2 在损失和样本的权重之间应该是负关系

- 3.3 模态的权重和其他模态的损失应该是正关系

联合置信度

Mono-Confidence

为了保证 3.2,一个直观的策略是使用每个模态的损失看来预测权重,从而建立一个负相关关系.但是使用损失作为模态融合的权重也带来了挑战.值得注意的是,随着训练过程的损失最小,即使是微小的偏差也会带来巨大的变化.此外,损失可能从 0 变成正无穷,为了解决这个问题,我们提出的用真实标签的概率来代替损失,损失的形式为.

因为只考虑了自己的模态置信度,我们将他定义为 Mono-Confidence

Holo-Confidence

对于 3.3,一个直观的想法就是用其他模态的损失作为权重,因此我们考虑使用其他模态的损失和来构建本模态的权重.根据

Co-Belief

把上面两个权重相加就行了.

Method

为了达到可靠的预测,我们提出多模态融合网络 PDF.

注意到通常数据的质量是动态变化的,导致预测的不可避免的不可靠性.为了减少 co-brief 潜在的不可靠性,我们提出了 Relative Calibration 从多模态的角度来进一步帮助预测共同信念.这样每个模态的权重都随着数据质量动态变化的

首先我们定义第 m 个模态的分布均匀度为:

其中C是类别数,mu是可能性的均值,也就是1/c,经过softmax的给了模型不确定性的一种重要见解.越均匀表示约不可靠.

靠谱绿岛环境的变化导致多模态系统的数据不确定性也是相对的.一种模态应该动态的感知其他模态的变化并且修改自己的权重.因此我们提出了Relative Calibration来校准每个模态的不确定度.第m个模态的不确定度如下:

考虑到真实世界的影响,RC以非对称形式进一步校准Co-Belief.特定来说如果RC<1的模态具有更大的不确定性,产生更大的不可靠.而大于1的那些保持就好了,基于此,修正的参数如下

修正的Co-Belief^m如下: 最终模型的输出如下: